Riesgos de la inteligencia artificial en España y su regulación

Cada minuto, en algún lugar de España, un sistema de inteligencia artificial toma decisiones que pueden afectar a tu privacidad, tu acceso a un empleo o la información que ves en tus redes. Muchas veces sin que lo sepas… y sin que puedas cuestionarlo.

La IA ya está en la sanidad, la banca, la educación, la justicia y la industria. Aporta eficiencia y nuevas oportunidades, pero también introduce riesgos que pueden comprometer derechos fundamentales y la seguridad colectiva.

En este artículo vas a ver, con ejemplos reales y el respaldo del marco legal más avanzado del mundo —el Reglamento Europeo de Inteligencia Artificial (AI Act)—, cuáles son esos riesgos, cómo se manifiestan en España y qué normas están llamadas a controlarlos. No es teoría: son situaciones que ya están ocurriendo y que marcarán el futuro inmediato de tu profesión y de la sociedad.

Principales riesgos de la inteligencia artificial en España

Riesgo 1: Sesgos algorítmicos y discriminación

Los sesgos algorítmicos aparecen cuando un sistema de inteligencia artificial aprende de datos que contienen prejuicios o representaciones incompletas de la realidad. Esto provoca que las decisiones automatizadas favorezcan a unos grupos y perjudiquen a otros.

En el contexto español, este desafío ya se ha identificado en:

- Empleo: filtros de currículums que descartan a mujeres en sectores tradicionalmente masculinos o a personas mayores de cierta edad.

- Banca: evaluaciones de riesgo que conceden menos crédito a perfiles con determinadas características sociales o geográficas.

- Justicia: sistemas de predicción que tienden a asociar mayor probabilidad de reincidencia a personas de ciertos orígenes o barrios.

Riesgo 2: Desinformación y deepfakes

La inteligencia artificial puede generar textos, imágenes, audios o vídeos falsos con un nivel de realismo que dificulta su detección. Este contenido manipulado —conocido como deepfake cuando se trata de material audiovisual— puede crearse en minutos y difundirse masivamente.

A nivel nacional, se han identificado riesgos como:

- Procesos electorales: circulación de vídeos falsos que imitan la voz o la imagen de candidatos para influir en el voto.

- Reputación personal o empresarial: suplantaciones en entrevistas, anuncios o comunicados que dañan la imagen pública.

- Seguridad ciudadana: difusión de noticias falsas durante emergencias, generando confusión y pánico.

Riesgo 3: Pérdida de privacidad y uso abusivo de datos

Muchos sistemas de inteligencia artificial se alimentan de grandes volúmenes de datos personales, incluyendo información sensible obtenida de redes sociales, historiales de navegación, cámaras de seguridad o registros administrativos. Mediante el análisis y correlación, la IA puede inferir aspectos como ideología política, estado de salud o hábitos de consumo.

En España, este riesgo se refleja en:

- Vigilancia masiva: uso de cámaras con reconocimiento facial en espacios públicos o eventos deportivos.

- Segmentación comercial invasiva: creación de perfiles publicitarios a partir de datos recogidos sin consentimiento informado.

- Filtraciones de datos: exposición de información médica o financiera por fallos de seguridad en sistemas automatizados.

Riesgo 4: Uso malicioso y cibercrimen potenciado por IA

Las herramientas de inteligencia artificial pueden emplearse para desarrollar ataques informáticos más sofisticados y difíciles de detectar. Esto incluye la creación de mensajes de phishing con lenguaje natural preciso, generación automática de malware y técnicas para vulnerar sistemas mediante patrones aprendidos.

En nuestro país, se han observado amenazas como:

- Phishing hiperrealista: correos que imitan con precisión el estilo y diseño de entidades bancarias o administraciones públicas.

- Ataques a infraestructuras críticas: intentos de sabotaje a redes eléctricas o sistemas de transporte usando algoritmos adaptativos.

- Suplantación en entornos corporativos: bots que imitan a directivos para solicitar transferencias o acceso a datos internos.

Riesgo 5: Impacto laboral y desplazamiento de empleos

La automatización impulsada por inteligencia artificial está transformando el mercado laboral, sustituyendo tareas que antes requerían intervención humana. Aunque genera nuevas oportunidades, existe riesgo real de pérdida de puestos en sectores con alta repetitividad o estandarización.

En España, los ámbitos más expuestos incluyen:

- Atención al cliente: reemplazo de operadores humanos por chatbots y asistentes virtuales.

- Transporte y logística: introducción de vehículos autónomos y sistemas de gestión automatizados.

- Procesos administrativos: uso de software inteligente para revisión de documentos, tramitación de expedientes o gestión de nóminas.

- Selección de personal: herramientas de filtrado y evaluación que desplazan funciones tradicionalmente humanas.

Riesgo 6: Opacidad y falta de explicabilidad

Muchos sistemas de inteligencia artificial funcionan como “cajas negras”, produciendo resultados sin que sea posible comprender con claridad cómo se han obtenido. Esta falta de explicabilidad dificulta la revisión de errores y la atribución de responsabilidades.

En el contexto español, esta opacidad puede presentarse en:

- Evaluaciones académicas o profesionales: sistemas que califican sin ofrecer criterios claros al evaluado.

- Concesión de créditos o seguros: algoritmos que aprueban o rechazan solicitudes sin justificación comprensible para el cliente.

- Procesos judiciales: herramientas de apoyo que generan recomendaciones sin acceso a la lógica interna de su funcionamiento.

Riesgo 7: Dependencia excesiva de la IA

Delegar de forma constante decisiones en sistemas de inteligencia artificial puede generar una confianza ciega en sus resultados, incluso sin evidencia suficiente sobre su precisión o adecuación. Esta dependencia reduce la capacidad crítica y la intervención humana en situaciones imprevistas.

En España, este riesgo se evidencia en:

- Diagnóstico médico asistido: profesionales que aceptan automáticamente la recomendación de un sistema sin contraste adicional.

- Gestión empresarial: decisiones estratégicas basadas únicamente en predicciones de modelos de IA.

- Administración pública: resoluciones emitidas con mínima supervisión humana, con impacto en derechos ciudadanos.

Riesgo 8: Concentración de poder tecnológico

El desarrollo y control de la inteligencia artificial se concentra en un reducido número de grandes corporaciones que dominan el acceso a datos, infraestructura y capacidades de innovación. Esto genera dependencia tecnológica y limita la soberanía en la toma de decisiones.

En España, esta concentración se traduce en:

- Dependencia de proveedores extranjeros: uso mayoritario de plataformas y modelos de IA desarrollados fuera de la UE.

- Desventaja competitiva para pymes y startups: falta de recursos para acceder a capacidades técnicas de grandes actores globales.

- Influencia en el mercado y la regulación: capacidad de las multinacionales para imponer estándares técnicos y condicionar marcos normativos.

Marco normativo: AI Act y legislación española

El AI Act es la propuesta de Reglamento de la Unión Europea que establece un marco legal específico para el desarrollo, comercialización y uso seguro y ético de sistemas de inteligencia artificial en todos los Estados miembros.

Objetivos principales del AI Act

Este reglamento persigue varios objetivos clave que marcan la base de todo su articulado:

- Proteger derechos fundamentales frente a usos de IA que puedan afectar a la igualdad, la privacidad o la seguridad.

- Garantizar la seguridad de productos y servicios que integran IA a lo largo de su ciclo de vida.

- Fomentar una innovación ética y competitiva en el mercado europeo, reduciendo asimetrías informativas y riesgos sistémicos.

Clasificación de niveles de riesgo

El AI Act agrupa los sistemas de IA en cuatro niveles según el impacto potencial:

- Riesgo inaceptable (prohibido): prácticas como la puntuación social generalizada o ciertos usos de identificación biométrica remota en tiempo real.

- Riesgo alto: sistemas utilizados en ámbitos sensibles (empleo, educación, servicios financieros, salud, justicia, infraestructuras críticas, dispositivos regulados), sometidos a requisitos estrictos.

- Riesgo limitado: obligaciones de transparencia (por ejemplo, avisos cuando se interactúa con un chatbot o cuando un contenido es sintético).

- Riesgo mínimo: aplicaciones con impacto bajo, sin obligaciones adicionales más allá de la normativa general aplicable.

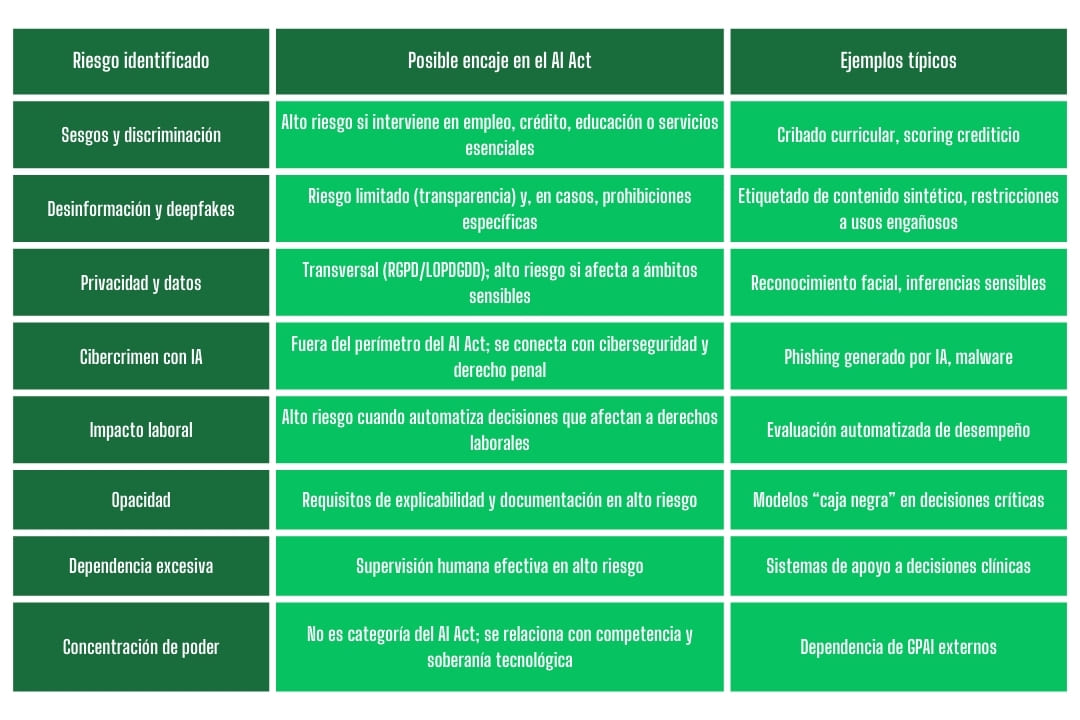

Relación orientativa con los riesgos anteriores:

Obligaciones según el rol

En función del papel que desempeñe cada agente, el AI Act establece obligaciones específicas:

- Proveedor (desarrolla o pone en el mercado): sistema de gestión de riesgos, gobernanza de datos, documentación técnica, registros de eventos (logging), evaluación de conformidad, instrucciones de uso y vigilancia poscomercialización.

- Desplegador/usuario empresarial: uso conforme a instrucciones, evaluación del propósito y contexto, calidad de datos propios, supervisión humana, registro de uso y respuesta ante incidentes.

- Importador: verificar que el sistema cumple antes de introducirlo en el mercado de la UE y que dispone de documentación y marcado.

- Distribuidor: comprobar integridad del etiquetado, documentación y trazabilidad antes de su comercialización.

Requisitos clave para sistemas de alto riesgo

Los sistemas de IA clasificados como de alto riesgo deberán cumplir, entre otros, los siguientes requisitos (arts. 9 a 15 del AI Act):

- Gestión y mitigación de riesgos: identificación, análisis, pruebas antes del despliegue y durante la operación.

- Calidad y gobernanza de datos: datasets pertinentes, libres de errores conocidos y sesgos detectables, con trazabilidad.

- Documentación y registro: expediente técnico, logging operativo y manuales claros para usuarios.

- Supervisión humana efectiva: definición de puntos de intervención, posibilidad real de anular o corregir decisiones.

- Ciberseguridad y robustez técnica: resistencia a ataques de manipulación de datos/modelos y planes de respuesta.

Normativa española aplicable

Además del AI Act, en España rige un marco legal propio que incluye, entre otras normas relevantes:

- RGPD (UE 2016/679) y LOPDGDD (LO 3/2018): principios de licitud del tratamiento, minimización de datos, obligación de realizar evaluaciones de impacto (DPIA) cuando proceda y garantías frente a decisiones exclusivamente automatizadas.

- Ámbitos sectoriales:

- Financiero: requisitos de solvencia, gobernanza y control interno aplicables a modelos de riesgo.

- Laboral: principios de igualdad y no discriminación; deber de información en sistemas de monitorización y evaluación automatizada.

- Justicia y seguridad: restricciones a la identificación biométrica y a tecnologías intrusivas.

- Audiovisual y publicidad: regulación de las comunicaciones comerciales y del uso de contenidos generados o modificados mediante IA.

Sanciones y consecuencias por incumplimiento

El incumplimiento del AI Act puede acarrear consecuencias significativas para las organizaciones, tanto en el plano económico como jurídico:

- Multas administrativas: graduadas según la gravedad de la infracción, con cuantías que pueden alcanzar hasta el 6 % de la facturación global anual en los supuestos más graves.

- Responsabilidad civil y contractual: por los daños causados a terceros, incluyendo reclamaciones por incumplimiento de obligaciones contractuales.

- Medidas correctoras y restricciones: imposición de acciones de subsanación, retirada de sistemas del mercado o prohibiciones temporales de uso por parte de las autoridades competentes.

Casos reales — Ejemplos españoles que ilustran cada riesgo

Uso de reconocimiento facial en espacios públicos y problemas de privacidad

En varias ciudades españolas, como Madrid y Barcelona, se han probado sistemas de reconocimiento facial para controlar accesos a recintos deportivos o reforzar la seguridad en eventos masivos. Estas prácticas han generado controversia por la recopilación masiva de datos biométricos, la ausencia de consentimiento expreso y la falta de garantías suficientes sobre su almacenamiento y uso, lo que ha llevado a intervenciones de la AEPD.

Deepfake viral que afecta a figura pública y consecuencias legales

En 2023, un vídeo manipulado que imitaba la voz y la imagen de un conocido político circuló por redes sociales, acumulando millones de visualizaciones en menos de 48 horas. El caso impulsó denuncias por vulneración del derecho al honor y a la propia imagen, y reavivó el debate sobre la autenticidad de la información en periodos electorales.

Algoritmo de selección laboral que discrimina por género o edad

Una investigación periodística reveló que una plataforma de contratación utilizaba un algoritmo que priorizaba candidaturas masculinas y descartaba perfiles mayores de 50 años. La filtración de documentos internos confirmó que el sesgo provenía de datos históricos no depurados, lo que derivó en una investigación de la Inspección de Trabajo por posible discriminación indirecta.

Ciberataque dirigido con herramientas de IA en empresa española

En 2024, una empresa del sector energético sufrió un ataque altamente sofisticado en el que se emplearon modelos de IA para generar correos de phishing personalizados con datos internos obtenidos de fugas previas. El incidente comprometió varias cuentas corporativas y provocó una interrupción de operaciones durante 72 horas, con pérdidas estimadas en más de 2 millones de euros.

Automatización en sector industrial y pérdida de empleo sin plan de transición

En una planta de producción automotriz situada en el País Vasco, la implementación de sistemas automatizados de inspección y ensamblaje redujo la plantilla en un 35 % en un periodo de seis meses. La ausencia de un plan de recualificación o recolocación generó protestas sindicales y abrió un debate público sobre la necesidad de medidas de transición justa en procesos de automatización.

Prepárate para gestionar los riesgos legales y éticos de la IA

Los riesgos y obligaciones que has visto no son un escenario teórico: ya están afectando a empresas, administraciones y ciudadanos en España. Su gestión exige profesionales capaces de interpretar el marco jurídico, aplicar criterios éticos y tomar decisiones con visión estratégica.

El Máster Universitario en Derecho y Ética de la Inteligencia Artificial de la Universidad Internacional de Andalucía está diseñado para formar a esos especialistas. Combina el análisis normativo más actual con casos prácticos y el acceso a un claustro con experiencia académica y aplicada. Te permitirá asesorar a organizaciones, participar en la elaboración de políticas y liderar proyectos en un área en plena expansión.